가장 간단한 단층 신경망을 생성하여 선형 모델을 돌려보자. 이 코드를 더 발전시키면 선형회귀분석을 할 수 있으니 기초 쌓기에 좋은 내용이 되겠다.

개요

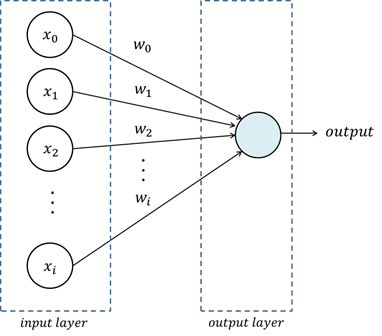

여기서 구현할 내용은 정확하게는 단층 퍼셉트론 구조를 가지는 신경망이다. 이는 다원 일차 방정식과 같으며 단순 선형 모델이다. 여기서 입력층(input layer)은 학습 벡터 또는 입력 벡터가 입력되는 계층이고, 출력층(output layer)은 1개 이상의 뉴런으로 구성할 수 있으며 뉴런의 개수에 따라 출력값의 개수가 정해진다.

데이터 준비

torch 패키지를 불러오고 10x4 행렬을 생성한다. 숫자를 고정하기 위해 torch_manual_seed() 함수를 사용하였다.

1 | library("torch") |

신경망 구조 정의

먼저 is_torch_tensor() 함수와 nn_parameter() 함수를 정의해주는데 원 코드 출처를 각각 표기해놓았다. 이는 torch 0.1.0 이상을 사용한다면 굳이 정의하지 않아도 되기 때문에 이 코드 블럭은 무시해도 관계 없다. 참고로 패키지 버전 확인은 다음과 같이 packageVersion() 함수를 사용하면 된다.

1 | packageVersion("torch") |

신경망의 입출력을 지정하기 위해서 udf_init() 함수를 생성한다. 초기값은 임의값을 생성하는 torch_randn() 함수와 0을 생성하는 torch_zeros() 함수를 사용하였다. 그리고 udf_mm() 함수는 신경망의 연산을 담당하는데 torch_mm() 함수가 matrix multiplication 으로 행렬곱을 수행한다. 즉, 입력된 데이터를 한 줄씩 읽어 self$w (가중치)와 곱연산을 하고 self$b 와 합연산을 하는 것이다. 그리고 이 모든 사항을 dense 객체에 저장한다.

1 | udf_init = function(in_features, out_features) { |

하이퍼파라미터 설정

모델에 입력되는 숫자는 4개, 출력은 1개로 각각 in_features 와 out_features 인자에 지정하였다. 신경망을 생성하면서 첫 줄에 torch_manual_seed() 함수를 사용하였는데 이는 udf_init() 함수에서 torch_randn()을 사용하였기 때문에 고정해주지 않으면 다른 값이 생성되기 때문이다. 그리고 생성된 값은 model$parameters 로 볼 수 있으며 가중치와 절편을 개별로 보고자 할 경우 model$w와 model$b로 각각 볼 수 있다.

1 | torch_manual_seed(123) |

학습

이제 데이터와 모델이 다 준비되었으니 데이터를 통과시킬 일만 남은 셈이다. 이 부분은 학습이라고 쓰긴 했지만 학습이라기 보다는 지정된 4원 1차 방정식에 숫자를 흘려보내는 그 이상도 이하도 아니다. y_pred_tensor 객체에 입력 데이터 10개 row에 대한 출력값 10개를 확인 할 수 있다.

1 | y_pred_tensor = model(x) |

평가

앞에서 생성한 출력물을 기본 R 객체로 변환하여 행렬 연산을 해보고 신경망으로 연산한 것과 비교해보면 다음과 같다.

1 | data_input = as.matrix(as_array(x)) |

RMSE로 비교한 결과 4.319239e-08 로 거의 0에 가까워 두 절차의 차이는 거의 없다고 볼 수 있다. 하지만 신경망이 더 복잡해진다면 차이가 얼마나 벌어질지는 확실하지 않다.